Generador de robots.txt

Utilice nuestra herramienta gratuita de generación de Robots.txt para crear un archivo Robots.txt para cualquier sitio web y gestionar eficazmente el rastreo restringiendo páginas sin importancia, reduciendo las solicitudes del rastreador y guardándolas para páginas importantes.

Acerca de Generador de robots.txt

El generador Robots.txt es una herramienta de Inteligencia Artificial que genera un archivo de texto. El archivo contiene las instrucciones para los motores de búsqueda. En otras palabras, el archivo controla la acción de rastreo de los motores de búsqueda.

El archivo Robots.txt contiene los detalles del contenido ocultos a los rastreadores de los motores de búsqueda. Según las instrucciones del archivo, los motores de búsqueda rastrearán o no las páginas. Usemos palabras simples. Los motores de búsqueda utilizan rastreadores para revisar el contenido del sitio web. Si desea ocultar una parte específica de su sitio web, colóquela en el archivo Robots.txt.

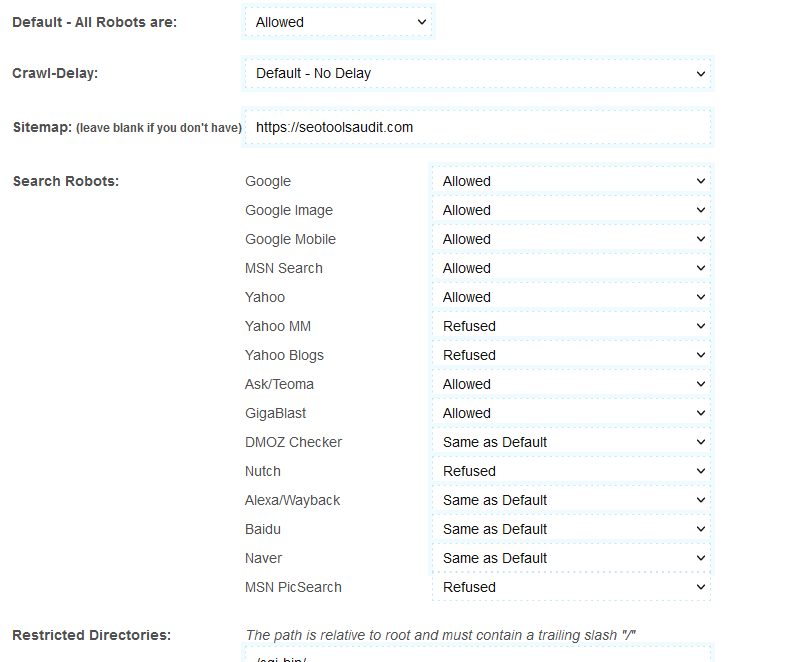

Mientras crea el archivo, el generador Robots.txt le permite elegir el motor de búsqueda. Por ejemplo, digamos que desea ocultar su contenido sólo de Yahoo y MSN; y desea permitir que Google lo haga. En ese caso, puede cambiar la configuración de la herramienta. Por ejemplo, seleccione "Permitir" en Google; y "Rechazar" en otros buscadores.

¿Qué es el generador Robots.txt?

El generador Robots.txt también se denomina Protocolo de exclusión de robots. El archivo de texto ayuda al usuario a categorizar el contenido de un sitio web, Primero; el usuario clasifica el contenido bueno y malo. Luego ingresan las instrucciones para ocultar o mostrar el contenido de los rastreadores de los motores de búsqueda en el archivo de texto.

¿Cómo utilizar el generador Robots.txt?

La herramienta es fácil de usar. Sin embargo, si es nuevo, siga estos pasos para conocer su uso:

- La opción Default-All Robots permite que todos los motores de búsqueda rastreen su sitio web. También puede utilizar esta opción para rechazar todos los motores de búsqueda.

- La opción de retraso de rastreo ralentiza la acción de rastreo de los motores de búsqueda. Google no admite esta opción. Entonces simplemente lo ignorará. Sin embargo, otros motores de búsqueda como Bing y Yahoo utilizan un retraso de rastreo de 10. Estos motores de búsqueda dividirán 24 horas (un día) en ventanas de diez segundos. Aproximadamente 8.640 ventanas. Rastrearán una página en una ventana.

- Luego viene el mapa del sitio. Deje esta opción en blanco si no tiene un mapa del sitio para su sitio web.

- Por último, verás opciones como Google, Yahoo, MSN , etc. Ahora, elige los motores de búsqueda que deseas permitir y aquellos de los que deseas ocultarte.

- Después de completar los detalles anteriores, haga clic en "Crear Robots.txt". La herramienta creará el archivo de texto por usted. Coloque el archivo al pie de su página web.

Beneficios del generador Robots.txt

Si escribe el archivo de texto manualmente, consume mucho tiempo. Pero puedes crear el archivo con la herramienta generadora de Robots.txt en cuestión de segundos. Todo lo que necesita hacer es seleccionar las opciones adecuadas y hacer clic en el botón "Crear Robots.txt".

El software también ofrece la oportunidad de guardar el archivo. Por lo tanto, puede crear y guardar varios archivos.

Características del generador Robots.txt

La herramienta le permite controlar el rastreo. También tiene funciones de retraso de rastreo. Si más de un rastreador ingresa a una página web simultáneamente, la respuesta de la página se divide entre los dos. Por lo tanto, todo el proceso lleva mucho tiempo. El retraso del rastreo ayuda a evitar estos problemas. Crea un retraso de tiempo entre dos rastreadores consecutivos. La herramienta tiene la opción de elegir los motores de búsqueda. Sería útil si permitiera o no permitiera los motores de búsqueda.

¿Cómo se puede mejorar el ranking SEO con el generador Robots.txt?

Es opcional colocar el archivo. Pero si lo hace, el archivo robots.txt mejora el rendimiento general y la clasificación SEO de su sitio web. Esto se debe a que los rastreadores encuentran la información muy rápidamente con Robots.txt. Con el archivo, no necesitan buscar contenido nuevo. En cambio, el archivo de texto los muestra todos. Por lo tanto, el tiempo total que el rastreador pasa en su sitio web es significativamente menor. Por lo tanto, los rastreadores de los motores de búsqueda creen que la experiencia del usuario de este sitio web es buena. La gente obtiene la información rápidamente.

En resumen, los rastreadores obtienen un buen informe sobre su sitio web con el archivo Robots.txt. De este modo, mejora el ranking SEO de su sitio web.

Preguntas frecuentes

¿El generador Robots.txt controla el rastreo?

La búsqueda de páginas nuevas y actualizadas en un sitio web se denomina rastreo. Y el generador Robots.txt puede controlar el rastreo. Mientras crea el archivo Txt, selecciona los motores de búsqueda a los que se les permitirá rastrear y a los que no se les permitirá rastrear.

¿El generador Robots.txt controla la indexación?

No. Sólo controla el rastreo. La indexación es diferente del rastreo. Es el proceso de organizar el contenido de un sitio web. El método de indexación crea conexiones entre las páginas y analiza los enlaces.

¿El generador de Robots.txt es lo mismo que el mapa del sitio?

No. El mapa del sitio contiene información sobre el sitio web. Los motores de búsqueda utilizan el mapa del sitio para tener una idea del contenido general del motor de búsqueda. Notifica a los motores de búsqueda sobre las páginas que requieren rastreo. Por otro lado, el archivo robots.txt es para rastreadores. El archivo de texto les dice a los rastreadores qué rastrear y qué no.

¿Cuáles son las directivas en el archivo Robots.txt?

Hay tres directivas diferentes utilizadas en el archivo robots.txt. Son rastreo-retraso, permiso y no permiso.

- El retraso del rastreo evita que los motores de búsqueda se sobrecarguen. Digamos que un motor de búsqueda envía varios rastreadores a una página web. La página se llena de gente y no responde. El retraso del rastreo evita estos problemas. Al retrasar los rastreadores de los motores de búsqueda, el archivo robots.txt agiliza el tráfico.

- La directiva "Permitir" permite indexar una URL. Utilice la función para agregar tantas URL como sea posible. Es de inmensa ayuda para los sitios de comercio electrónico. Los sitios web de compras tienen listas largas.

- La directiva "No permitir" impide que los rastreadores visiten los enlaces incluidos.

¿Puedo agregar una directiva "No permitir" en la página principal?

Puedes. Pero ayudaría si no lo hicieras. Los motores de búsqueda funcionan con un presupuesto de rastreo fijo. Establecen un presupuesto de rastreo particular para cada sitio web. La página de inicio es como el corazón del sitio web.

Cuando no permite la página principal, los rastreadores asumen que su sitio no está listo para ser indexado. y bloquear la página de inicio podría provocar un aumento en la profundidad de rastreo, ya que la página de inicio es la página principal que generalmente enlaza con todo el sitio web.

Por lo tanto, esto provocará una disminución en el acceso a la cantidad de páginas y publicaciones por parte del rastreador para obtener actualizaciones. Por lo tanto, es aconsejable no utilizar la directiva "No permitir" en la página principal.

LATEST BLOGS

Buscar

-

Herramientas de SEO populares

- Comprobador de plagio

- Herramienta de parafraseo

- Comprobador de posición de palabras clave

- Corrector gramatical

- Comprobador de autoridad de dominio

- Comprobador de estadísticas de PageSpeed

- Image Compression Tool

- Búsqueda inversa de imágenes

- Page Authority checker

- Text To Speech

- Comprobador de vínculos de retroceso

- Creador de vínculos de retroceso

- Domain Age Checker

- Website Ping Tool

- Revisor del sitio web

- Comprobador de densidad de palabras clave

- Comprobador de tamaño de página

- Contador de palabras

- Comprobador de Mozrank