Générateur de robots.txt

Utilisez notre outil gratuit de génération Robots.txt pour créer un fichier Robots.txt pour n'importe quel site Web et gérer efficacement l'exploration en limitant les pages sans importance, en réduisant les requêtes des robots et en les enregistrant pour les pages importantes.

À propos Générateur de robots.txt

Le générateur Robots.txt est un outil d'intelligence artificielle qui génère un fichier texte. Le fichier contient les instructions pour les moteurs de recherche. En d’autres termes, le fichier contrôle l’action d’exploration des moteurs de recherche.

Le fichier Robots.txt contient les détails du contenu cachés aux robots des moteurs de recherche. Sur la base des instructions contenues dans le fichier, les moteurs de recherche doivent ou non parcourir les pages. Utilisons des mots simples. Les moteurs de recherche utilisent des robots pour examiner le contenu du site Web. Si vous souhaitez masquer une partie spécifique de votre site Web, placez-la dans le fichier Robots.txt.

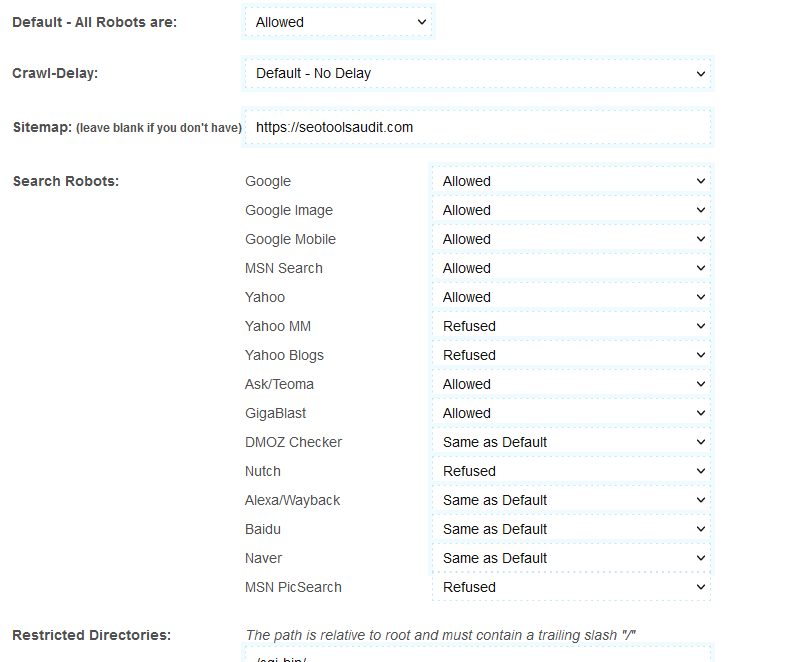

Lors de la création du fichier, le générateur Robots.txt permet de choisir le moteur de recherche. Par exemple, disons que vous souhaitez masquer votre contenu uniquement à Yahoo et MSN ; et vous souhaitez permettre à Google de le faire. Dans ce cas, vous pouvez modifier les paramètres de l'outil. Par exemple, sélectionnez « Autoriser » sur Google ; et "Rejeter" dans d'autres moteurs de recherche.

Qu'est-ce que le générateur Robots.txt ?

Le générateur Robots.txt est également appelé Robots Exclusion Protocol. Le fichier texte aide l'utilisateur à catégoriser le contenu d'un site Web : d'abord ; l'utilisateur trie les bons et les mauvais contenus. Ensuite, ils saisissent les instructions pour masquer ou afficher le contenu des robots des moteurs de recherche dans le fichier texte.

Comment utiliser le générateur Robots.txt ?

L'outil est facile à utiliser. Cependant, si vous êtes nouveau, veuillez suivre ces étapes pour en savoir plus sur son utilisation :

- L'option Default-All Robots permet à tous les moteurs de recherche d'explorer votre site Web. Vous pouvez également utiliser cette option pour rejeter tous les moteurs de recherche.

- L' option crawl-delay ralentit l'action d'exploration des moteurs de recherche. Google ne prend pas en charge cette option. Il va donc simplement l'ignorer. Cependant, d'autres moteurs de recherche comme Bing et Yahoo utilisent un délai d'exploration de 10. Ces moteurs de recherche diviseront 24 heures (un jour) en fenêtres de dix secondes. Environ 8 640 fenêtres. Ils exploreront une page dans une fenêtre.

- Vient ensuite le plan du site. Laissez cette option vide si vous n'avez pas de plan du site pour votre site Web.

- Enfin, vous verrez des options comme Google, Yahoo, MSN , etc. Maintenant, choisissez les moteurs de recherche que vous souhaitez autoriser et ceux dont vous souhaitez vous cacher.

- Après avoir rempli les détails ci-dessus, cliquez sur « Créer Robots.txt ». L'outil créera le fichier texte pour vous. Placez le fichier au pied de votre page Web.

Avantages du générateur Robots.txt

Si vous écrivez le fichier texte manuellement, cela prend beaucoup de temps. Mais vous pouvez créer le fichier avec l'outil générateur Robots.txt en quelques secondes. Tout ce que vous avez à faire est de sélectionner les options appropriées et de cliquer sur le bouton "Créer Robots.txt".

Le logiciel offre également la possibilité de sauvegarder le fichier. Par conséquent, vous pouvez créer et enregistrer plusieurs fichiers.

Caractéristiques du générateur Robots.txt

L'outil vous permet de contrôler l'exploration. Il possède également des fonctionnalités de retard d’exploration. Si plusieurs robots d'exploration accèdent simultanément à une page Web, la réponse de la page est divisée entre les deux. Par conséquent, l’ensemble du processus prend du temps. Le délai d'exploration permet d'éviter de tels problèmes. Cela crée un délai entre deux robots consécutifs. L'outil a la possibilité de choisir les moteurs de recherche. Cela aiderait si vous autorisiez ou interdisiez les moteurs de recherche.

Comment améliorer le classement SEO avec le générateur Robots.txt ?

Il est facultatif de placer le fichier. Mais si vous le faites, le fichier robots.txt améliore les performances globales et le classement SEO de votre site Web. En effet, les robots trouvent les informations très rapidement avec Robots.txt. Avec le fichier, ils n’ont pas besoin de rechercher de nouveaux contenus. Au lieu de cela, le fichier texte les donne tous. Ainsi, le temps global que le robot passe sur votre site Web est nettement inférieur. Par conséquent, les robots des moteurs de recherche estiment que l’expérience utilisateur de ce site Web est bonne. Les gens obtiennent l'information rapidement.

En fin de compte, les robots d'exploration établissent un bon rapport sur votre site Web avec le fichier Robots.txt. Ainsi, le classement SEO de votre site Web s’améliore.

FAQ

Le générateur Robots.txt contrôle-t-il l'exploration ?

La recherche de pages nouvelles et mises à jour sur un site Web s'appelle l'exploration. Et le générateur Robots.txt peut contrôler l'exploration. Pendant que vous créez le fichier Txt, vous sélectionnez les moteurs de recherche qui doivent être autorisés à explorer et non autorisés à explorer.

Le générateur Robots.txt contrôle-t-il l'indexation ?

Non, il contrôle uniquement l’exploration. L'indexation est différente de l'exploration. C'est le processus d'organisation du contenu sur un site Web. La méthode d'indexation crée des liens entre les pages et analyse les liens.

Le générateur Robots.txt est-il le même que le plan du site ?

Non. Le plan du site contient des informations sur le site Web. Les moteurs de recherche utilisent le plan du site pour avoir une idée du contenu global détenu par le moteur de recherche. Il informe les moteurs de recherche des pages nécessitant une exploration. D’un autre côté, le fichier robots.txt est destiné aux robots d’exploration. Le fichier texte indique aux robots d'exploration ce qu'ils doivent explorer et ce qu'ils ne doivent pas explorer.

Quelles sont les directives du fichier Robots.txt ?

Trois directives différentes sont utilisées dans le fichier robots.txt. Il s'agit du délai d'exploration, de l'autorisation et de l'interdiction.

- Le délai d'exploration empêche la surcharge des moteurs de recherche. Supposons qu'un moteur de recherche envoie plusieurs robots d'exploration vers une page Web. La page devient encombrée et ne répond plus. Le délai d'exploration évite de tels problèmes. En retardant les robots des moteurs de recherche, le fichier robots.txt rationalise le trafic.

- La directive "Autoriser" permet d'indexer une URL. Utilisez la fonctionnalité pour ajouter autant d'URL que possible. C’est d’une immense aide pour les sites de commerce électronique. Les sites Web Shopping ont de longues listes.

- La directive « Disallowing » empêche les robots de visiter les liens inclus.

Puis-je ajouter une directive « Interdire » sur la page principale ?

Vous pouvez. Mais cela aiderait si vous ne le faisiez pas. Les moteurs de recherche fonctionnent avec un budget d’exploration fixe. Ils fixent un budget d'exploration particulier pour chaque site Web. La page d'accueil est comme le cœur du site Web.

Lorsque vous refusez la page principale, les robots d'exploration supposent que votre site n'est pas prêt à être indexé. et le blocage de la page d'accueil pourrait entraîner une augmentation de la profondeur d'exploration, car la page d'accueil est la page principale qui renvoie généralement à l'ensemble du site Web.

Cela entraînera donc une diminution de l’accès au nombre de pages et de publications par le robot pour les mises à jour. Par conséquent, il est conseillé de ne pas utiliser la directive « Disallow » sur la page principale.

LATEST BLOGS

Recherche

-

Outils de référencement populaires

- Vérificateur de plagiat

- Outil de paraphrase

- Vérificateur de position des mots clés

- Vérificateur de grammaire

- Vérificateur d'autorité de domaine

- Vérificateur d'informations PageSpeed

- Image Compression Tool

- Recherche d'image inversée

- Page Authority checker

- Text To Speech

- Vérificateur de backlinks

- Créateur de backlinks

- Domain Age Checker

- Website Ping Tool

- Réviseur de site Web

- Vérificateur de densité de mots clés

- Vérificateur de taille de page

- Compteur de mots

- Vérificateur Mozrank