Gerador Robots.txt

Use nossa ferramenta gratuita de geração de Robots.txt para criar um arquivo Robots.txt para qualquer site e gerenciar o rastreamento de maneira eficaz, restringindo páginas sem importância, reduzindo solicitações do rastreador e salvando-as para páginas importantes.

Sobre Gerador Robots.txt

O gerador Robots.txt é uma ferramenta de Inteligência Artificial que gera um arquivo de texto. O arquivo contém as instruções para os mecanismos de pesquisa. Em outras palavras, o arquivo controla a ação de rastreamento dos motores de busca.

O arquivo Robots.txt contém os detalhes do conteúdo ocultos dos rastreadores do mecanismo de pesquisa. Com base nas instruções do arquivo, os motores de busca devem ou não rastrear as páginas. Usemos palavras simples. Os mecanismos de pesquisa usam rastreadores para revisar o conteúdo do site. Se você quiser ocultar uma parte específica do seu site, coloque-a no arquivo Robots.txt.

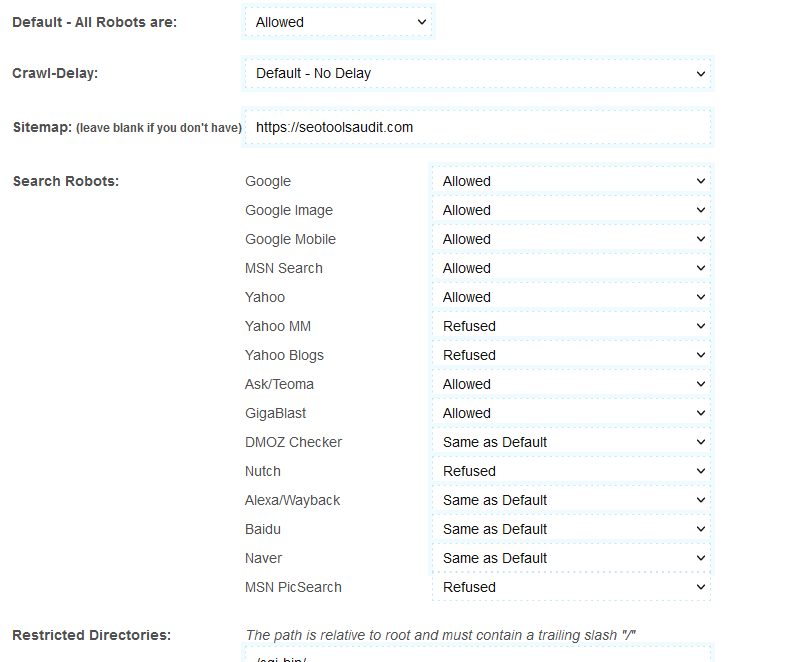

Ao criar o arquivo, o gerador Robots.txt permite escolher o mecanismo de busca. Por exemplo, digamos que você queira ocultar seu conteúdo apenas do Yahoo e do MSN; e você deseja permitir que o Google faça isso. Nesse caso, você pode alterar as configurações da ferramenta. Por exemplo, selecione “Permitir” no Google; e "Rejeitar" em outros motores de busca.

O que é o gerador Robots.txt?

O gerador Robots.txt também é chamado de Protocolo de Exclusão de Robôs. O arquivo de texto ajuda o usuário a categorizar o conteúdo de um site, primeiro; o usuário classifica o conteúdo bom e ruim. Em seguida, eles inserem instruções para ocultar ou mostrar o conteúdo dos rastreadores do mecanismo de pesquisa no arquivo de texto.

Como usar o gerador Robots.txt?

A ferramenta é fácil de usar. No entanto, se você for novo, siga estas etapas para aprender sobre seu uso:

- A opção Default-All Robots permite que todos os mecanismos de pesquisa rastreiem seu site. Você também pode usar esta opção para rejeitar todos os mecanismos de pesquisa.

- A opção crawl-delay retarda a ação de rastreamento dos mecanismos de pesquisa. O Google não oferece suporte a esta opção. Portanto, ele simplesmente irá ignorá-lo. No entanto, outros mecanismos de busca como Bing e Yahoo usam um atraso de rastreamento de 10. Esses mecanismos de busca dividirão 24 horas (um dia) em janelas de dez segundos. Aproximadamente 8.640 janelas. Eles rastrearão uma página em uma janela.

- Em seguida vem o mapa do site. Deixe esta opção em branco se você não tiver um mapa do site para o seu site.

- Por fim, você verá opções como Google, Yahoo, MSN , etc. Agora, escolha os mecanismos de pesquisa que deseja permitir e aqueles dos quais deseja ocultar.

- Após preencher os detalhes acima, clique em “Criar Robots.txt”. A ferramenta criará o arquivo de texto para você. Coloque o arquivo no final da sua página da web.

Benefícios do gerador Robots.txt

Se você escrever o arquivo de texto manualmente, isso consumirá muito tempo. Mas você pode criar o arquivo com a ferramenta geradora Robots.txt em segundos. Tudo que você precisa fazer é selecionar as opções adequadas e clicar no botão "Criar Robots.txt".

O software também oferece a oportunidade de salvar o arquivo. Portanto, você pode criar e salvar vários arquivos.

Recursos do gerador Robots.txt

A ferramenta permite controlar o rastreamento. Ele também possui recursos de atraso de rastreamento. Se mais de um rastreador entrar em uma página da Web simultaneamente, a resposta da página será dividida entre os dois. Portanto, todo o processo se torna demorado. O atraso do rastreamento ajuda a evitar esses problemas. Ele cria um atraso entre dois rastreadores consecutivos. A ferramenta tem a opção de escolher os motores de busca. Ajudaria se você permitisse ou proibisse mecanismos de pesquisa.

Como você pode melhorar a classificação de SEO com o gerador Robots.txt?

É opcional colocar o arquivo. Mas se você fizer isso, o arquivo robots.txt melhorará o desempenho geral do seu site e a classificação SEO. Isso ocorre porque os rastreadores encontram as informações muito rapidamente com o Robots.txt. Com o arquivo, eles não precisam procurar novos conteúdos. Em vez disso, o arquivo de texto fornece todos eles. Portanto, o tempo total que o rastreador passa no seu site é significativamente menor. Portanto, os rastreadores dos mecanismos de pesquisa acreditam que a experiência do usuário deste site é boa. As pessoas obtêm as informações rapidamente.

Resumindo, os rastreadores obtêm um bom relatório sobre o seu site com o arquivo Robots.txt. Assim, a classificação SEO do seu site melhora.

Perguntas frequentes

O gerador Robots.txt controla o rastreamento?

A pesquisa de páginas novas e atualizadas em um site é chamada de rastreamento. E o gerador Robots.txt pode controlar o rastreamento. Ao criar o arquivo Txt, você seleciona os mecanismos de pesquisa que terão permissão e não permissão para rastrear.

O gerador Robots.txt controla a indexação?

Não. Ele controla apenas o rastreamento. A indexação é diferente do rastreamento. É o processo de organização do conteúdo de um site. O método de indexação cria conexões entre as páginas e analisa os links.

O gerador Robots.txt é igual ao mapa do site?

Não. O Sitemap contém informações sobre o site. Os mecanismos de pesquisa usam o mapa do site para ter uma ideia sobre o conteúdo geral mantido pelo mecanismo de pesquisa. Ele notifica os mecanismos de pesquisa sobre as páginas que requerem rastreamento. Por outro lado, o arquivo robots.txt é para rastreadores. O arquivo de texto informa aos rastreadores o que rastrear e o que não rastrear.

Quais são as diretivas no arquivo Robots.txt?

Existem três diretivas diferentes usadas no arquivo robots.txt. Eles são atraso de rastreamento, permissão e proibição.

- O atraso do rastreamento evita a sobrecarga dos mecanismos de pesquisa. Digamos que um mecanismo de pesquisa esteja enviando vários rastreadores para uma página da web. A página fica lotada e sem resposta. O atraso do rastreamento evita esses problemas. Ao atrasar os rastreadores do mecanismo de pesquisa, o arquivo robots.txt agiliza o tráfego.

- A diretiva "Permitir" permite a indexação de uma URL. Use o recurso para adicionar tantos URLs quanto possível. É de imensa ajuda para sites de comércio eletrônico. Os sites de compras possuem listas extensas.

- A diretiva "Disallowing" impede que os rastreadores visitem os links incluídos.

Posso adicionar uma diretiva "Não permitir" na página principal?

Você pode. Mas ajudaria se você não fizesse isso. Os mecanismos de pesquisa funcionam com um orçamento de rastreamento fixo. Eles definem um orçamento de rastreamento específico para cada site. A página inicial é como o coração do site.

Quando você desativa a página principal, os rastreadores presumem que seu site não está pronto para ser indexado. e bloquear a página inicial pode causar um aumento na profundidade do rastreamento, já que a página inicial é a página principal que geralmente leva a todo o site.

Então, isso causará uma diminuição no acesso ao número de páginas e posts pelo rastreador para atualizações. Portanto, é aconselhável não utilizar a diretiva “Disallow” na página principal.

LATEST BLOGS

Procurar

-

Ferramentas populares de SEO

- Verificador de plágio

- Ferramenta de paráfrase

- Verificador de posição de palavra-chave

- Verificador gramatical

- Verificador de autoridade de domínio

- Verificador de insights do PageSpeed

- Image Compression Tool

- Pesquisa reversa de imagens

- Page Authority checker

- Text To Speech

- Verificador de backlinks

- Criador de backlinks

- Domain Age Checker

- Website Ping Tool

- Revisor do site

- Verificador de densidade de palavras-chave

- Verificador de tamanho de página

- Contador de palavras

- Verificador Mozrank